L'intelligence artificielle (IA) représente une avancée technologique majeure aux implications profondes dans tous les aspects de la société moderne. De plus, ce phénomène s'est accéléré avec l'arrivée des IA génératives telles que Mistral, ChatGPT, Gemini etc.

De la santé à la finance en passant par l'industrie et les services publics, l'IA promet des avantages considérables.

Cependant, son déploiement soulève également des préoccupations éthiques, sociales et juridiques, poussant les gouvernements à créer des règles pour encadrer son usage

En avril 2024, l’Union européenne a adopté l’AI Act, première loi mondiale dédiée à l’intelligence artificielle.

La régulation de l’IA est en pleine expansion mondiale, avec des approches diversifiées selon les contextes juridiques, priorités (droits fondamentaux, sécurité, innovation) et maturité institutionnelle. Par exemple, aux Etats-Unis, on compte une centaine de lois en cours d’adoption sur des enjeux variés (discrimination algorithmique, deepfakes, protection des consommateurs, etc.). Des États comme le Colorado ou l’Utah ont déjà promulgué des lois notables.

C'est quoi l'AI Act ?

L'AI Act, ou RIA (Règlement (UE) 2024/1689), est une réglementation conçue pour encadrer et promouvoir le développement ainsi que la mise sur le marché des systèmes d'intelligence artificielle au sein de l'Union européenne.

Lancé par la Commission européenne en avril 2021, l'AI Act est entré en vigueur le 12 juillet 2024, après trois années de négociations.

Cette initiative a pour but de favoriser le développement d'une IA de confiance, garantissant les droits fondamentaux, la sécurité et les principes éthiques, tout en encourageant et en renforcent l’investissement et l’innovation de l’IA dans l’ensemble de l’UE.

Définition de l'intelligence artificielle

L'intelligence artificielle (IA) sert à automatiser des tâches, analyser des données, prendre des décisions, personnaliser les expériences utilisateur et créer des systèmes autonomes dans divers domaines tels que la santé, la finance, la fabrication et bien d'autres encore.

Le développement d'une intelligence artificielle implique la conception, l'entraînement et l'optimisation d'algorithmes et de modèles informatiques pour permettre à un système de simuler des processus cognitifs humains ou d'accomplir des tâches spécifiques de manière autonome.

Le système d'intelligence artificielle est développé en utilisant diverses techniques d'apprentissage, les principales sont les suivantes :

- Apprentissage supervisé : dans cette méthode, le modèle d'IA est entraîné sur un ensemble de données étiquetées, où chaque exemple de données est associé à une étiquette ou une sortie désirée.

- Apprentissage non supervisé : le modèle d'IA est exposé à des données non étiquetées et cherche à découvrir des structures ou des modèles intrinsèques à ces données.

- Apprentissage par renforcement : un agent qui interagit avec un environnement dynamique et reçoit des récompenses ou des pénalités en fonction des actions qu'il prend.

Les systèmes d’IA peuvent apprendre et s’adapter à partir des données, tandis que les outils classiques se limitent à exécuter des instructions prédéfinies.

L’intelligence artificielle ne se réduit pas à l’exécution de commandes : elle implique la capacité de raisonner et de s’adapter en fonction de l’expérience.

**Pour comprendre la différence entre un modèle d'IA et un système d'IA, cliquez ici.

Pourquoi la régulation de l'intelligence artificielle est-elle nécessaire ?

Le règlement sur l'IA vise à instaurer la confiance des citoyens européens dans les technologies de l'Intelligence artificielle. Bien que certains systèmes d'IA présentent peu de risques et contribuent à résoudre divers défis sociétaux d'autres posent de réels risques.

D'où l'intérêt des exigences de l'AI Act qui viennent:

- Cibler les risques spécifiques associés à l'IA (erreurs, des biais cognitifs, de la discrimination ou des impacts sur la protection des données)

- Interdire les pratiques d'IA présentant des risques inacceptables (unacceptable risk)

- Définir des critères clairs pour les systèmes d'IA utilisés dans ces applications

- Imposer des obligations spécifiques aux utilisateurs et fournisseurs fournisseurs de systèmes de ces applications

- Exiger une évaluation de la conformité avant la mise en service ou la commercialisation d'un système d'IA

- Surveiller l'application des règles après la commercialisation d'un système d'IA

- Mettre en place une structure de gouvernance aux niveaux européen et national.

Qui est concerné par l'AI Act?

L’AI Act s’applique uniquement aux systèmes et aux cas d'usages relevant du droit de l’Union européenne. Il régit la mise sur le marché, la mise en service et l’utilisation des systèmes d’IA dans l’UE, qu’ils soient développés au sein de l’Union ou importés de pays tiers.

Les acteurs concernés correspondent à l'ensemble des acteurs intervenant dans le cycle de vie d’un système d’IA, c'est-à-dire les fournisseurs, les déployeurs, les importateurs et distributeurs.

Cependant, il existe quelques exclusions notables du champ d'application du RIA (Article 2), tel que :

- les activités à des fins militaires, de défense ou de sécurité nationale;

- les systèmes d'IA développés et mis en service exclusivement à des fins de recherche et développement scientifiques;

- l'utilisation de systèmes d'IA par des personnes physiques pour des activités strictement personnelles et non professionnelles.

- les modèles open sources dans certaines conditions.

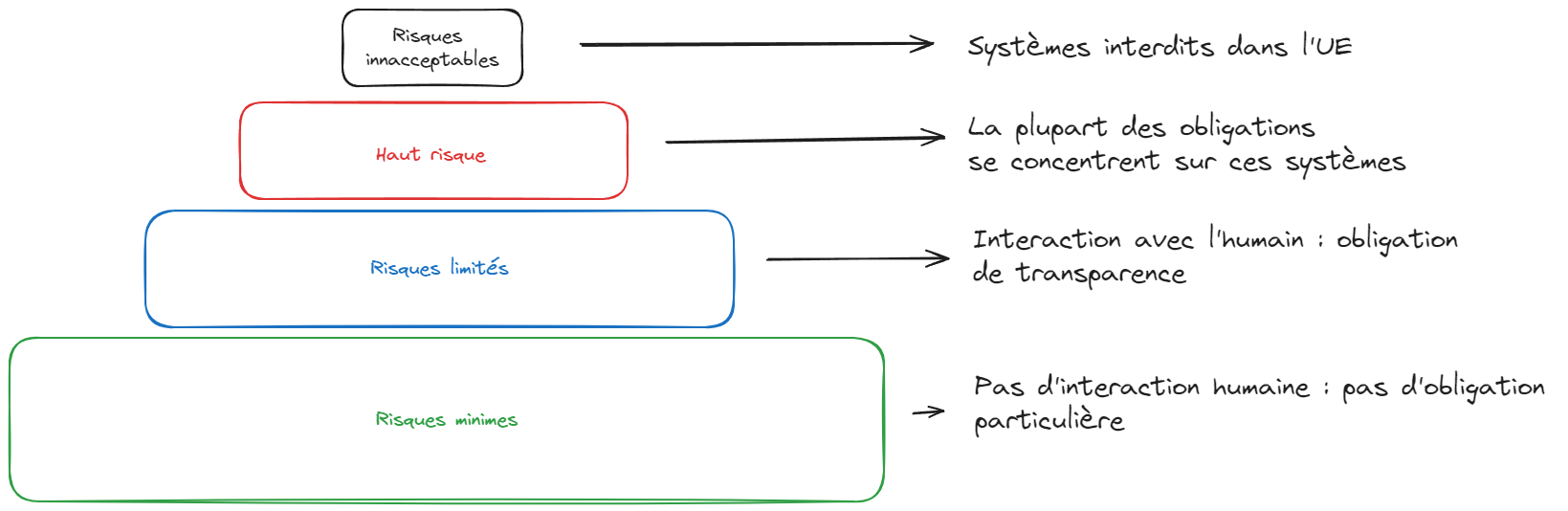

Les niveaux de risques

L'approche qu'adopte l'AI Act est fondée sur les risques. Le cadre réglementaire établit 4 catégories de risque pour les systèmes d'intelligence artificielle (SIA). Les acteurs mentionnés plus haut doivent donc s'assurer du respect des exigences du RIA en fonction du niveau de risque.

Cela concerne les SIA à objectif spécifique, pour lesquels le risque est évalué en fonction de leur cas d’usage concret (ex: ressources humaines), et non les modèles d'IA à usage général (GPAI) qui bénéficient d'un traitement particulier en raison de leurs capacité à effectuer des tâches distinctes, parfois imprévisibles.

Les risques inacceptables (unacceptable risk) :

Les systèmes et modèles d'intelligence artificielle présentant un risque inacceptable ne peuvent être mis sur le marché ni utilisés à l'exportation dans l'Union européenne. Il s'agit des systèmes d'IA considérés comme une menace claire pour la sécurité, les moyens de subsistance et les droits des personnes, de la notation sociale par les gouvernements aux jouets utilisant une assistance vocale qui encourage les comportements dangereux.

Exemples : scoring social, lidentification biométrique généralisée, deepfakes, manipulation de contenu, etc.)

Les risques élevés ou SIA à haut risque (high risk AI systems) :

Les systèmes d'IA à haut risque jugés à haut risque constituent le coeur des exigences du RIA. Ils peuvent être divisés en 2 catégories.

La première correspond aux SIA qui sont intégrés à des produits eux-mêmes couverts par une législation sectorielle existante en matière de sécurité (par exemple la directive sur la sécurité des jouets). Une évaluation de conformité par un organisme tiers notifié sera obligatoire pour ces systèmes.

La seconde correspond aux SIA qui relèvent des domaines cités dans l'Annexe III de l'AI Act, telles que :

Les infrastructures critiques telles que les transports, pouvant mettre en péril la vie et la santé des citoyens.

L'éducation et la formation professionnelle;

L'emploi, la gestion des employés et l'accès au travail indépendant, par exemple avec l'utilisation de logiciels de tri de CV pour les processus de recrutement.

Exemple: analyse des émotions sur le lieu de travail : L’utilisation de l’IA pour analyser les émotions ou classifier biométriquement les employés est interdite en raison des risques liés à la vie privée et à la discrimination.

Les services publics et privés essentiels

Exemple: scoring social à des fins commerciales : L’IA ne peut être utilisée pour évaluer ou classer des individus en fonction de leur comportement social ou de caractéristiques personnelles entraînant un traitement injuste ou discriminatoire.

Systèmes d’IA manipulateurs : Toute IA exploitant des techniques subliminales pour influencer le comportement d’une personne de manière significative, avec un risque de préjudice physique ou psychologique. Les entreprises doivent éviter toute IA manipulant les consommateurs de manière nocive.

Les systèmes d'IA à haut risque doivent respecter des obligations strictes avant d'être autorisés sur le marché, comprenant :

- L'implémentation de méthodes d'évaluation et de réduction des risques adéquates.

- L'utilisation de ensembles de données de haute qualité pour minimiser les risques et éviter les résultats discriminatoires.

- La tenue d'un registre de logs pour garantir la traçabilité des résultats.

- La création d'une documentation détaillée fournissant toutes les informations nécessaires sur le système et son objectif, afin de permettre aux autorités d'évaluer sa conformité.

- La fourniture d'informations claires et appropriées pour les utilisateurs.

- La mise en place de mesures de surveillance humaine pour minimiser les risques.

- Le maintien d'un niveau élevé de robustesse, de sécurité et de précision.

Tous les systèmes d'identification biométrique à distance sont considérés comme présentant un haut risque et sont donc soumis à des exigences strictes. L'utilisation de tels systèmes dans des espaces publics à des fins répressives est fondamentalement interdite.

Des exceptions sont autorisées dans des circonstances spécifiques et réglementées de manière stricte, telles que la prévention d'une menace terroriste imminente.

Attention: Un système d’IA qui n’était pas initialement classé comme « à haut risque » peut acquérir ce statut dans plusieurs situations :

Modification substantielle de ses fonctionnalités ou de son mode de fonctionnement : dans ce cas, l’entité qui adapte ou redéploie le système est considérée comme fournisseur au sens de l’AI Act, avec toutes les obligations associées ;

Évolution des données traitées, modifiant la nature ou l’impact du système ;

Réutilisation dans un cas d’usage à haut risque, tel que défini à l’Annexe III de l’AI Act.

Les risques limités/modérés :

Un risque limité ou modéré fait référence aux dangers liés au manque de transparence dans l'utilisation de l'intelligence artificielle.

La législation sur l'IA introduit des obligations spécifiques en matière de transparence pour assurer que les individus sont informés lorsque cela est nécessaire, renforçant ainsi la confiance.

Exemple : lors de l'interaction avec des systèmes d'IA tels que les chatbots, les individus doivent être informés qu'ils communiquent avec une machine, afin qu'ils puissent prendre une décision éclairée sur la poursuite ou la rétractation de leur interaction.

Les fournisseurs devront donc garantir que le contenu produit par l'IA est identifiable. De plus, les textes générés par l'IA et publiés dans le but d'informer le public sur des questions d'intérêt général devront être clairement indiqués comme étant générés par l'intelligence artificielle.

Cette exigence s'applique également aux contenus audio et vidéo qui pourraient constituer des deepfakes.

Les risques minimes ou nul:

Le RIA autorise l'utilisation libre de l'IA présentant un risque minimal. La plupart des systèmes d'IA actuellement en utilisation dans l'UE entrent dans cette catégorie. Il n'existe pas d'obligations particulières, mais l'adhésion à des codes de conduite est favorisée.

Exemple : Bot de jeux vidéos, filtres antispams etc.

Quelles sont les sanctions en cas de non-respect de l'AI Act ?

Des pénalités significatives, similaires à celles prévues par le RGPD en cas de non-respect du Règlement, sont envisagées pour les infractions à l'AI Act.

Le non-respect du règlement entraîne des sanctions, y compris des amendes administratives. Les montants maximaux varient en fonction de la gravité de l'infraction et de la taille de l'entreprise.

En cas de non-conformité aux règles concernant les risques inacceptables, une amende pouvant atteindre 30 millions d'euros ou 7% du chiffre d'affaires pour les entreprises est prévue (selon le montant le plus élevé). Pour les autres violations de l'AI Act, l'amende peut s'élever à 20 millions d'euros ou 5% du chiffre d'affaires pour les entreprises.

Le règlement prévoit des amendes pour le défaut de coopération avec les autorités nationales de l'Union européenne, pouvant aller jusqu'à 10 millions d'euros ou 2% du chiffre d'affaires.

Ce régime de sanctions entrera en vigueur le 2 août 2026, bien que les interdictions de l’article 5 soient applicables dès le 2 février 2025.

Dès cette date, les entreprises qui enfreignent ces interdictions pourraient faire face à des poursuites civiles, administratives ou pénales en vertu d’autres lois de l’UE, comme la réglementation sur la responsabilité des produits ou le RGPD, en cas de traitement illicite de données personnelles.

Les personnes physiques ou morales peuvent introduire une réclamation auprès de l'autorité de surveillance du marché concernée (Article 85) et ont droit à une explication concernant les décisions prises par les systèmes d'IA (Article 86).

Calendrier d'application échelonnée du RIA

- 2 février 2025 : Application des dispositions générales et du chapitre concernant les pratiques interdites.

- 2 août 2025 : Application du chapitre concernant les autorités notifiantes et organismes notifiés), du chapitre concernant l'IA à usage général, du chapitre concernant la gouvernance, du chapitre relatif aux sanctions.

- 2 août 2026 : Applicabilité générale du règlement.

- 2 août 2027 : Application des obligations spécifiques liées aux systèmes d'IA à haut risque, composants de sécurité de produits (Article 6 §1).

- 2 août 2030 : Les fournisseurs et déployeurs de systèmes d'IA à haut risque destinés à être utilisés par des autorités publiques doivent se conformer aux exigences et obligations du règlement.

Gouvernance

L’AI Act repose sur une architecture institutionnelle à deux niveaux – nationale et européenne – afin d’assurer une application harmonisée de la réglementation dans l’ensemble de l’Union.

1. Au niveau national : autorités de surveillance

Chaque État membre doit désigner des autorités nationales compétentes, chargées de :

surveiller le marché et contrôler les systèmes d’IA,

vérifier les évaluations de conformité,

désigner et superviser les organismes notifiés habilités à réaliser des audits,

appliquer les sanctions en cas de non-conformité.

La désignation de l’autorité nationale compétente est attendue en août 2025. Cette dernière devra collaborer étroitement avec le Bureau de l’IA européen pour garantir la cohérence de la mise en œuvre.

2. Au niveau européen : pilotage centralisé

Au sein de la Commission européenne, le Bureau de l’IA de l’UE (EU AI Office) constitue l'institution maîtresse de la supervision, en particulier pour les modèles d’IA à usage général (GPAI) et pour les fournisseurs de modèles d’IA, qui doivent se conformer aux exigences de transparence, de sécurité et de traçabilité définies par l’AI Act.

Il s’appuie sur deux organes consultatifs :

Le Comité IA (AI Board), qui réunit États membres, société civile, acteurs économiques et académiques, afin d’éclairer les orientations réglementaires et d’intégrer une diversité de points de vue.

Le Panel scientifique consultatif, composé d’experts indépendants, chargé d’identifier les risques systémiques, d’émettre des recommandations techniques et de contribuer à la définition des critères de classification des modèles.

3. Objectif

Ce dispositif vise à garantir une gouvernance rigoureuse, transparente et scientifiquement fondée, afin d’accompagner entreprises et citoyens dans un cadre réglementaire en constante évolution.

Conclusion

L’AI Act constitue un tournant historique : il définit un cadre juridique clair pour les fournisseurs de systèmes et les utilisateurs de l’IA, en s’appuyant sur une logique de gestion des risques (unacceptable risk → interdiction, IA à haut risque → conformité obligatoire).

En pratique, cela signifie que toutes les organisations utilisant ou développant des modèles d’IA devront se préparer à respecter les obligations fixées, que ce soit via des procédures internes, des registres de conformité ou l’adoption d’un code de bonne pratique.

Répondre aux exigences de l'AI Act avec Dastra

Notre logiciel Dastra, vous aidera très facilement à mettre en place la conformité à la réglementation de l'AI Act. Dastra inclut désormais un registre des systèmes d'IA complet avec analyse des risques intégrées, cartographie des actifs, données et modèles d'IA concernés.

Et si vous souhaitez en lire davantage, consultez l'article suivant de cette "Série IA" : Premiers pas vers une gouvernance efficace de l'IA